[LARPSICO] ¿Escudos humanos contra la violencia digital? Riesgos psicosociales en las nuevas profesiones de vigilancia tecnológica

- La profesión “moderador de contenidos” es un exponente de la necesidad de prevención de los riesgos psicosociales en el ámbito de los nuevos empleos digitales

- Los protocolos de gestión de la salud mental son la necesaria garantía de protección de los riesgos psicosociales

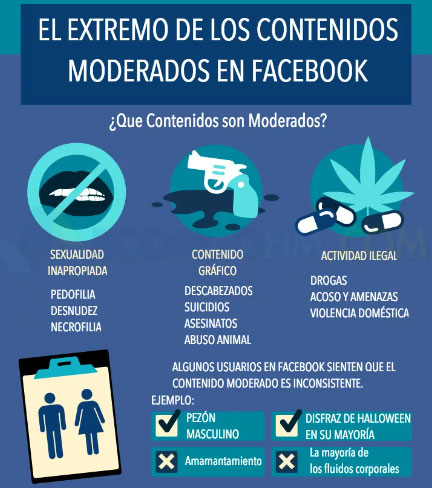

Moderador de contenidos, nueva profesión de alta tensión y fuente de obligaciones laborales con carga psicosocial. La mayoría de las aplicaciones que se utiliza a diario, redes sociales, foros, chats, plataformas, juegos online, nacieron sin límites, esto es, sin una protección de uso y de los contenidos que se visionaban. Ante la conciencia creciente de que la red se podía convertir en un universo de delincuencia y abusos – violencia, pornografía – se comenzaron a poner límites a través del establecimiento de filtros y normas de comportamiento. La mayoría del contenido se revisa de forma automática por sistemas de inteligencia artificial creados específicamente para cada plataforma, pero casi siempre, las decisiones de esta IA tienen que ser confirmadas por unos “ojos” humanos, pertenecientes a una persona que lee, escucha y ve todo lo que el resto del mundo no quiere ver. Actúan pues, como escudos humanos de internet.

Estos “ojos” humanos se han convertido en una nueva profesión, moderador de contenidos, tan demandada que tras una busca rápida en LinkedIn son cerca de 400 000 personas. El filtrado de vídeos, fotos, mensajes y cualquier tipo de contenido, se ha convertido en un gran negocio para consultoras y corporaciones que acaparan los contratos con las grandes redes sociales – Facebook, Twitter, Youtube, Instagram… -, que también cuentan con sus propios moderadores de plantilla.

Ni el número de personas que trabajan en esta actividad ni su condición de profesión emergente vinculada a las nuevas tecnologías, hace que esté exenta de riesgos y, evidentemente los riesgos a los que se enfrentan son los riesgos psicosociales. En los últimos tiempos las alarmas han saltado a través de reportajes como 'The trauma floor' en “The Verge”, que evidencia las condiciones en las que trabajan los moderadores de contenidos, que trata el caso particular de una empresa en Arizona que Facebook utiliza para realizar estas tareas.

El trabajo de una persona moderadora de contenidos consiste en visualizar contenido sensible en internet. En los procesos selectivos se les visualiza este tipo de materiales y se les pregunta si serían capaces de soportarlo. Algunas empresas aportan apoyo psicológico. Los problemas exceden del consumo de contenidos. La implicación en algunos casos a veces es inevitable. Además, estas personas no están aisladas, sino en contacto con los usuarios de las plataformas con lo que asumen el riesgo adicional de comunicaciones hostiles (mensajes de acoso, creación de perfiles falsos con fotos suyas y calificaciones, por ejemplo, de pedofilia), sin que exista una norma que prohíba este tipo de acciones, con las consecuencias psicosociales que conllevan. Es más, en algunos países como EEUU se ha cuestionado la idoneidad de la formación del colectivo.

La necesidad del establecimiento de protocolos de gestión de la salud mental. Este nuevo sector profesional reclama, pues, mayor atención por las políticas de protección de los riesgos psicosociales, generando nuevas obligaciones de gestión de estos puestos de trabajo para todas y cada una de las personas que desarrollen sus servicios en un entorno digital por lo que se sumarían al inventario de riesgos psicosociales derivados de la digitalización. En el ámbito del Consejo de Europa, la Recomendación CM/Rec (2020) 1 del Comité de ministros a los Estados miembros sobre los impactos de los sistemas algorítmicos en los derechos humanos subraya que “deben incentivar la innovación tecnológica de acuerdo con los derechos humanos existentes, incluidos los derechos sociales y las normas laborales y de empleo reconocidas internacionalmente”. Entre las fórmulas adoptadas por los diferentes países como respuesta a esta realidad, la disposición adicional centésimo trigésima de la Ley 22/2021, de 28 de diciembre, de Presupuestos Generales del Estado para el año 2022, que autoriza al Gobierno a impulsar una Ley para la creación de la Agencia Española de Supervisión de Inteligencia Artificial en España, entre cuyos cometidos estaría el desarrollo de “medidas destinadas a la minimización de riesgos significativos sobre la seguridad y salud de las personas así como sobre sus derechos fundamentales”.

Un riesgo más a sumar a la ya larga lista recogida en el informe sobre los “riesgos emergentes en materia de seguridad y salud en el trabajo asociados con la digitalización para 2025”, elaborado en 2018 por la Agencia Europea para la Seguridad y la Salud en el Trabajo, que, entre los principales desafíos en materia de seguridad y salud en el trabajo vinculados al fenómeno de la digitalización, destaca los “factores psicosociales y organizativos derivados de los cambios que los avances tecnológicos pueden impulsar en los tipos de trabajo disponibles, el ritmo de trabajo, en el cómo, dónde y cuándo se hacen esos trabajos, y en cómo se gestionan y supervisan”.

La respuesta ante la inacción de la empresa en materia de evaluación de riesgos psicosociales. Pese a los vacíos normativos existentes, la casuística planteada ya empieza a frutos. La Generalitat, a través de la Dirección General de Relaciones Laborales, Trabajo Autónomo, Seguridad y Salud Laboral ha sancionado con 41.000 euros a una empresa de Barcelona - CCC Barcelona Digital Services - que presta sus servicios a la red Facebook, por el trastorno mental grave que sufrió un empleado suyo – moderador de contenidos – desarrollado a partir de la visualización de contenido muy violento en internet. Multan a la empresa porque consideran una infracción grave no evaluar los riesgos psicosociales de esta tarea y el impacto que estaba teniendo en su trabajador, que estuvo durante siete meses, de septiembre de 2018 a mayo de 2019, visionando contenido violento en internet, básicamente relacionado con terrorismo y suicidios. Su función era la de bloquear este tipo de imágenes y por eso tuvo que ver íntegramente y varias veces videos de decapitaciones, automutilaciones o tortura para asegurarse de que la política que se aplicaba a este material era la correcta.

La respuesta ante la inacción de la empresa en materia de evaluación de riesgos psicosociales. Pese a los vacíos normativos existentes, la casuística planteada ya empieza a frutos. La Generalitat, a través de la Dirección General de Relaciones Laborales, Trabajo Autónomo, Seguridad y Salud Laboral ha sancionado con 41.000 euros a una empresa de Barcelona - CCC Barcelona Digital Services - que presta sus servicios a la red Facebook, por el trastorno mental grave que sufrió un empleado suyo – moderador de contenidos – desarrollado a partir de la visualización de contenido muy violento en internet. Multan a la empresa porque consideran una infracción grave no evaluar los riesgos psicosociales de esta tarea y el impacto que estaba teniendo en su trabajador, que estuvo durante siete meses, de septiembre de 2018 a mayo de 2019, visionando contenido violento en internet, básicamente relacionado con terrorismo y suicidios. Su función era la de bloquear este tipo de imágenes y por eso tuvo que ver íntegramente y varias veces videos de decapitaciones, automutilaciones o tortura para asegurarse de que la política que se aplicaba a este material era la correcta.

El acta de la Inspecció de Treball de Catalunya ha constatado que el trabajador estaba expuesto a un riesgo psicosocial derivado de la "propia naturaleza" de la actividad, así como de las condiciones del trabajo de la empresa. Entre las condiciones destacan el ritmo, la carga de trabajo, las exigencias emocionales. La Generalitat confirma el criterio de la Inspección de Trabajo, que considera acreditado que la visualización de este contenido tiene la capacidad de perturbar la salud mental y que la empresa no disponía de un sistema de evaluación del impacto que estas imágenes estaban provocando en el empleado. Además de la tarea en sí, la autoridad laboral también entiende que la carga de trabajo y las exigencias emocionales perjudicaron la salud del trabajador.

No existe aún jurisprudencia en este sentido y para esta profesión en nuestro país, pero sí precedentes en otros como EEUU. Una trabajadora de Facebook presentó una demanda por un cuadro de estrés postraumático desarrollado por su trabajo como moderadora de contenidos y cuyos primeros síntomas comenzaron a los nueve meses de haber comenzado a estar en contacto con este material. La demanda incluía a 11.250 personas moderadoras en diferentes estados, dio lugar a un acuerdo de compensaciones económicas en función de los daños certificados vinculados a la exposición. En cualquier caso, las actuaciones resultantes van en el camino de la reparación – económica fundamentalmente - y no de la prevención, con lo cual el problema sigue sin resolverse.

Horario de atención telefónica: de 09:00 a 14:30 horas

Compartir en

La agencia

La agencia